L’Intelligence Artificielle n’est plus l’apanage des serveurs distants. Grâce à l’émergence de modèles de langage légers et d’outils performants, vous pouvez désormais exécuter une IA puissante (un Grand Modèle de Langage ou LLM) directement sur votre ordinateur personnel.

Ce tutoriel utilise LM Studio, l’outil le plus simple et le plus populaire pour démarrer une IA locale, garantissant confidentialité et gratuité.

Pourquoi l’IA Locale ?

Faire tourner une IA en local offre plusieurs avantages cruciaux :

- Confidentialité Totale : Vos données et vos conversations ne quittent jamais votre machine.

- Gratuité & Illimitation : Accès illimité aux modèles sans frais d’abonnement ou de jetons (tokens).

- Rapidité (Hors-Ligne) : Possibilité d’utiliser l’IA même sans connexion Internet.

Étape 1 : Installation de LM Studio

LM Studio est une application gratuite tout-en-un qui facilite la découverte, le téléchargement et l’exécution de modèles.

- Téléchargement : Rendez-vous sur le site officiel de LM Studio et téléchargez la version correspondant à votre système d’exploitation (Windows, Mac ou Linux).

- Installation : Lancez le fichier téléchargé et suivez les instructions simples pour l’installer.

Étape 2 : Choisir et Télécharger Votre Modèle (GGUF)

LM Studio utilise principalement des modèles optimisés au format GGUF, qui permettent d’utiliser à la fois le CPU (processeur) et le GPU (carte graphique) pour des performances optimales.

- Recherche : Dans l’interface de LM Studio, utilisez la barre de recherche pour trouver des modèles.

- Recherchez :

Mistral(pour un bon équilibre entre performance et taille) ouLlama 3(pour des performances de pointe).

- Recherchez :

- Choix de la Version Optimisée : Les modèles sont souvent proposés en plusieurs versions, indiquées par la quantification (par exemple, Q4_K_M).

- Q4_K_M : Bon compromis entre performance et taille de fichier.

- Q8_0 : Meilleures performances, mais nécessite plus de RAM/VRAM.

- Téléchargement : Cliquez sur le bouton de téléchargement à côté de la version GGUF souhaitée (ex. :

mistral-7b-instruct-v0.2.Q4_K_M.gguf). Le fichier pèsera généralement entre 4 Go et 8 Go.

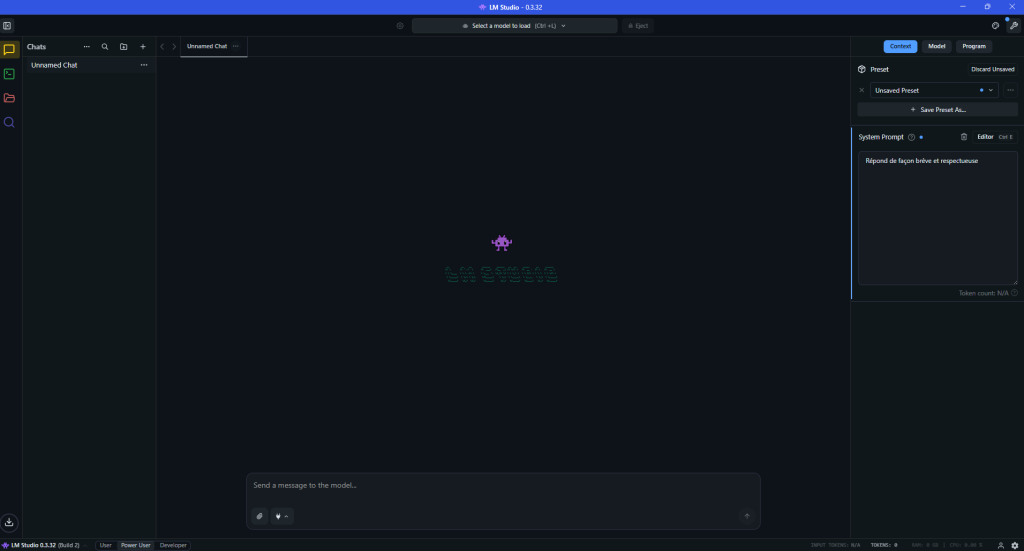

Étape 3 : Lancer la Conversation

Une fois le modèle téléchargé, vous êtes prêt à le faire tourner en local.

- Sélectionner le Chat : Cliquez sur l’icône de « Chat » dans la barre latérale gauche (souvent la troisième icône, représentant une bulle de dialogue).

- Charger le Modèle : Dans le panneau supérieur, utilisez le menu déroulant pour sélectionner le fichier

Mistral(ou tout autre modèle) que vous venez de télécharger. - Régler les Paramètres (Optionnel) : Dans la colonne de droite, vous pouvez affiner les réglages :

- Hardware Settings : C’est l’étape la plus importante. Si vous avez un GPU qui tient la route, réglez le curseur GPU offload au maximum, pour décharger le travail sur votre carte graphique et accélérer la vitesse de réponse.

- Vous pouvez également rédiger un « System Prompt », il s’agit d’un prompt persistant que l’IA prendra en compte avant chaque réponse. (Exemple: Répond se façon brève et respectueuse)

- Démarrer : Le modèle se charge. Une fois que la zone de texte inférieure indique « Prompt », vous pouvez commencer à interagir !

Exemple de Prompt :

Expliquez le concept du Big Bang en utilisant uniquement 50 mots.

Félicitations ! Vous utilisez désormais un modèle d’Intelligence Artificielle puissant et totalement privé, hébergé sur votre propre machine.

Retour de ping : Cocorico : Les meilleurs modèles d'IA LLM français - IA